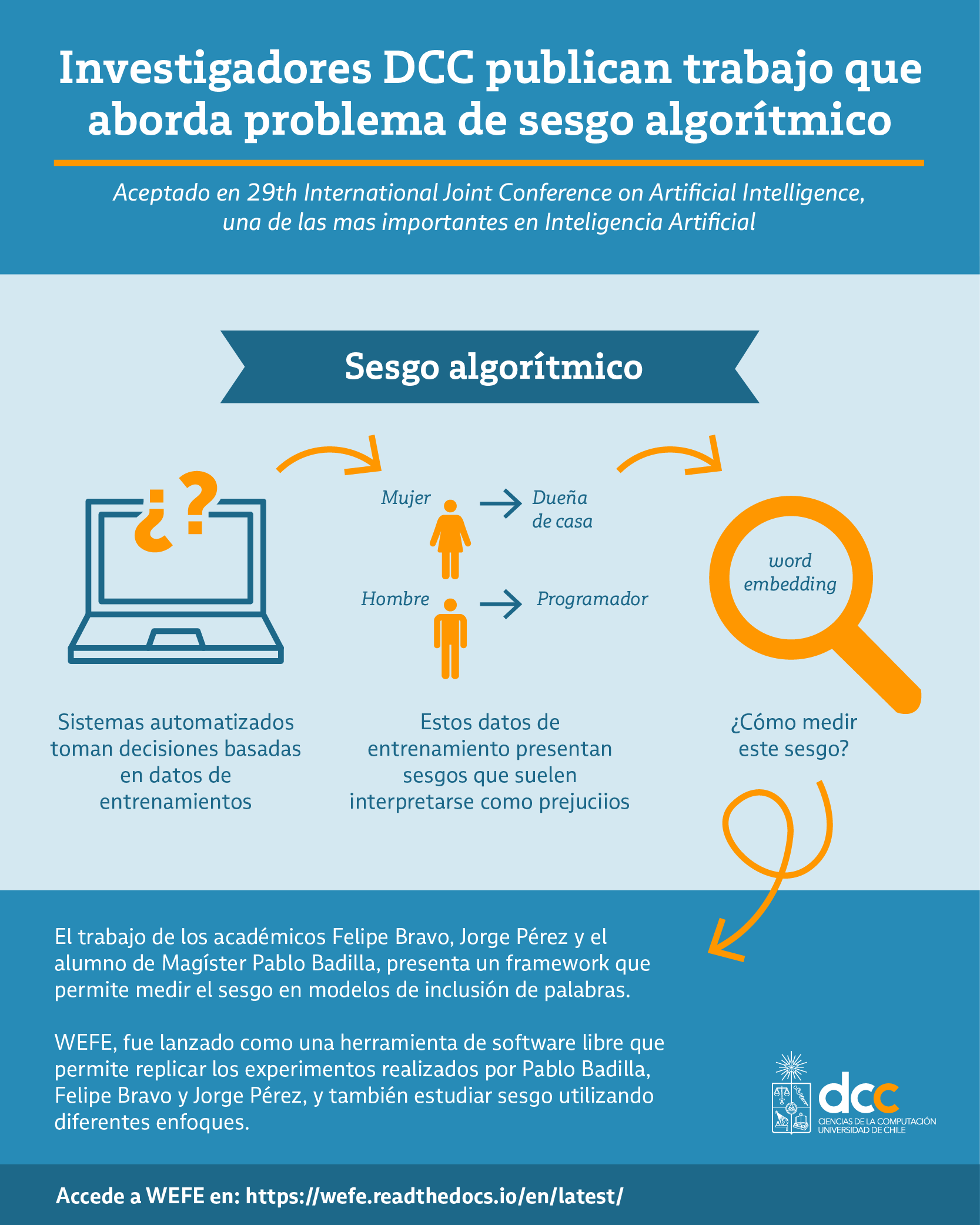

El sesgo algorítmico es quizás hoy uno de los grandes problemas de investigación en inteligencia artificial. Éstos ocurren cuando sistemas automatizados "toman decisiones" basados en datos de entrenamiento que –como su nombre lo indica— presentan sesgos que muchas veces suelen interpretarse como prejuicios. Un ejemplo clásico es el de la búsqueda de un candidato para un puesto de trabajo, donde el sistema podría seleccionar solo varones o solo mujeres, basado en los datos que maneja para esa decisión.

Muchos de los datos utilizados para entrenar estos modelos corresponden a palabras (representadas en word embedding). Pero ¿cómo medir el sesgo en la inclusión de esas palabras? Es el problema que abordan Felipe Bravo y Jorge Pérez, ambos académicos DCC e investigadores del Instituto Milenio Fundamento de los Datos, y el estudiante de Magíster Pablo Badilla, quienes presentaron el trabajo de investigación "WEFE: The Word Embeddings Fairness Evaluation Framework", el cual fue aceptado en la 29th International Joint Conference on Artificial Intelligence (IJCAI 2020), una de las conferencias más importantes en inteligencia artificial, con una tasa de tasa de aceptación de 12.6%.

"Las word embedding son representaciones vectoriales densas de palabras formadas a partir de un corpus de documentos. Se han convertido en un componente central de los sistemas de procesamiento del lenguaje natural (PNL), debido a su capacidad de capturar eficientemente las relaciones semánticas y sintácticas entre las palabras", explicó el profesor Felipe Bravo.

El académico señaló que una deficiencia ampliamente reportada de estas word embeddings es que son propensas a heredar prejuicios sociales estereotipados en lo relativo a temas como género, etnia o religión, entre otros, todos estos exhibidos en los documentos en los que se entrenan. "Estos sesgos suelen mostrar que algunos atributos, por ejemplo, profesiones, actitudes, rasgos, están más fuertemente asociados a un grupo social en particular que a otro. Un ejemplo ilustrativo es la relación vectorial entre las palabras "hombre" y "mujer" siendo similar a la relación entre las palabras "programador" y "ama de casa". En este contexto se han propuesto varias métricas de "fairness" para cuantificar automáticamente estos sesgos. Aunque todas las métricas tienen un objetivo similar, la relación entre ellas no es en absoluto clara. Dos cuestiones que impiden una comparación clara es que operan con inputs diferentes, y que sus outputs son incompatibles entre sí", expresó el profesor Bravo.

Respondiendo a la falta de formalización en los métodos para medir este sesgo, los investigadores desarrollaron WEFE, que según explicó el académico, es "un framework para encapsular, evaluar y comparar las métricas de fairness. Requiere una lista de word embeddings pre-entrenados y un conjunto de criterios de fairness. Se basa en la comprobación de las correlaciones entre los rankings inducidos por estos criterios. Llevamos a cabo un caso de estudio que muestra que los ranking producidos por los métodos de fairness existentes tienden a correlacionarse cuando se mide el sesgo respecto al género. Esta correlación es considerablemente menor para otros sesgos como la raza o la religión".

WEFE, fue lanzado como una herramienta de software libre que permite replicar los experimentos realizados por Pablo Badilla, Felipe Bravo y Jorge Pérez, y también estudiar sesgo utilizando diferentes enfoques.

Accede a WEFE en: https://wefe.readthedocs.io/en/latest/

--

Comunicaciones DCC

- Tags